Le sommet sur l'éthique de l'IA 2025 à Genève expose des règles pratiques concernant la confidentialité, l'emploi et la sécurité. Découvrez comment la gouvernance transfrontalière pourrait orienter une IA responsable.

Réponse rapide

Le sommet sur l’éthique de l’IA 2025 à Genève redéfinit la manière dont nous governons les IA puissantes. Le cœur du débat tourne autour de l’éthique de la surveillance, du déplacement des emplois, de la sécurité et de la frontière entre l’innovation et le contrôle. Des sondages post-événement préliminaires suggèrent environ 62 % en faveur de règles internationales, tandis que 38 % s’interrogent sur les lacunes d’application. Les compromis clés portent sur la transparence, la supervision humaine et une responsabilité claire en cas d’usage abusif. L’instant est moins celui d’arrêter le progrès que celui de l’orienter de manière responsable.

À retenir : Le sommet sur l’éthique de l’IA 2025 porte moins sur l’arrêt de l’IA que sur la codification de règles communes protégeant la vie privée, les emplois et la sécurité tout en maintenant l’innovation sur la bonne voie.

Guide complet du sommet sur l’éthique de l’IA 2025

Le sommet genevois sur l’éthique de l’IA 2025 est arrivé à un tournant : des systèmes puissants passent des démonstrations en laboratoire à des déploiements réels dans les soins de santé, la finance, la sécurité publique et l’énergie. Ce guide décompose les grandes thématiques, les propositions de gouvernance en jeu et les implications pratiques pour les décideurs politiques, les entreprises et les citoyens. Attendez-vous à des débats sur les pactes internationaux, les standards exécutables et l’équilibre entre déploiement rapide et mitigation des risques.

Contexte et enjeux

- Le sommet a réuni des présidents, des premiers ministres, des dirigeants d’entreprises et des chercheurs de premier plan pour discuter de la gouvernance mondiale de l’IA. Les délégués soutiennent qu’en l’absence de règles communes, l’innovation pourrait dépasser la supervision, entraînant des dérives vers des usages nuisibles ou un accès inégal aux avantages.

- Les défenseurs de l’industrie plaident pour des standards flexibles axés sur les résultats qui puissent s’adapter à une technologie en rapide évolution, tandis que les régulateurs exigent des critères explicites, des protocoles de test et des cadres de responsabilité. Cette tension a façonné les propositions les plus importantes de la journée.

Propositions politiques et cadres

- Les piliers de la gouvernance internationale mettent l’accent sur la transparence, la supervision humaine en boucle, la sécurité par conception et la responsabilité tant pour les développeurs que pour les déployeurs. Plusieurs volets ont proposé des évaluations d’impact obligatoires avant le lancement, similaires à des revues environnementales mais axées sur les biais, la confidentialité et les risques de sécurité.

- La responsabilité et les mécanismes de réparation sont au cœur du dialogue. Les propositions explorent qui est responsable lorsque l’IA cause du tort : le développeur, l’opérateur, la plateforme ou un modèle de responsabilité partagée avec des assureurs.

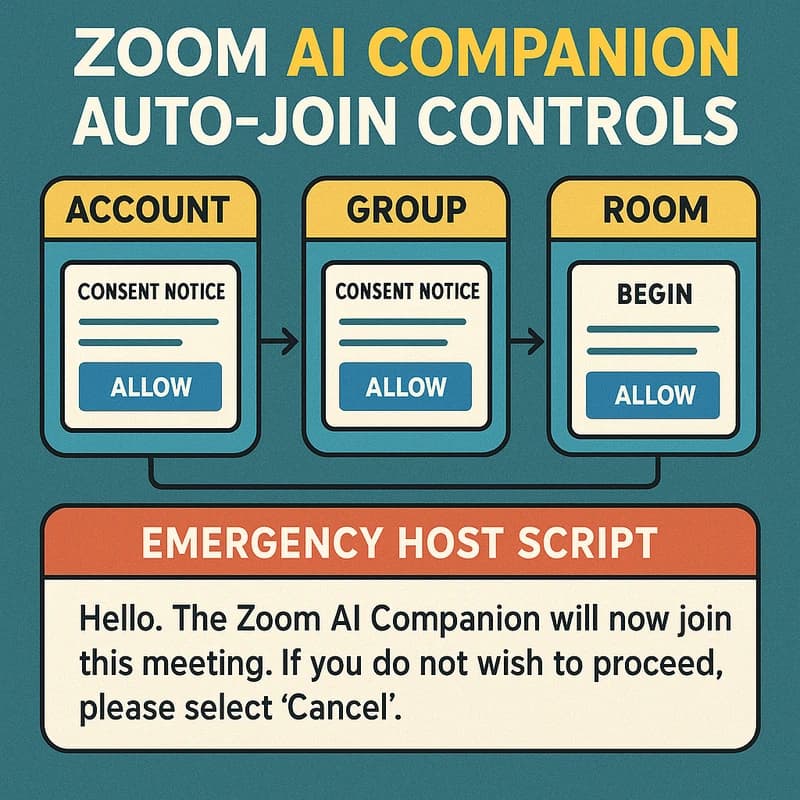

- L’éthique de la surveillance occupe une place centrale, avec des appels à des restrictions strictes sur le déploiement de la reconnaissance faciale, des exigences de provenances des données et des normes explicites de consentement/opt-in pour les ensembles de données sensibles.

Implications pratiques par secteur

- Santé: les régulateurs examinent des standards pour la confidentialité des données des patients, l’explicabilité des décisions cliniques et la surveillance post-market des outils assistés par IA. Les partisans mettent en avant des diagnostics plus rapides et plus précis, tandis que les sceptiques mettent en garde contre les biais de données et les lacunes de responsabilité.

- Emploi: les décideurs ont discuté des investissements dans la reconversion, de la mitigation du déplacement d’emplois et des filets de sécurité sociale alors que l’IA automatise des tâches routinières. L’objectif est de préserver la stabilité des ménages tout en permettant aux travailleurs de se reconvertir vers des postes à skills plus élevés.

- Défense et sécurité: l’éthique de la guerre IA était au centre, avec des débats sur les armes autonomes, les risques d’escalade et la nécessité de normes ou de traités internationaux qui limitent ou supervisent certains usages.

Gouvernance globale et coopération

- Le sommet a souligné la nécessité d’une approche multi-niveaux: régulations nationales alignées sur des standards internationaux de référence, plus un partage d’informations transfrontalier sur les incidents de sécurité et les évaluations de risques. Le cadre d’un « sommet sur l’éthique de l’IA à Genève 2025 » ressemblant à une architecture potentielle pour la gouvernance globale a gagné en substance.

- Les parties prenantes ont insisté sur le renforcement des capacités dans les régions à revenu faible afin d’assurer un accès équitable aux outils IA sûrs et à l’expertise de gouvernance, réduisant le risque d’un fossé technologique qui s’élargit en fossé géopolitique.

Signaux et sentiment du monde réel

- Des analyses précoces de think tanks et d’observateurs de l’industrie indiquent une poussée robuste en faveur de règles concrètes et exécutables plutôt que de principes aspirants. Le débat évolue vers la façon de rendre les règles vérifiables, auditable et adaptables aux technologies émergentes.

- Le discours public, amplifié par les plateformes sociales, oscille entre optimisme pour les avancées en soins de santé et en modélisation climatique, et préoccupations liées à la surveillance, aux biais et au risque d’armement.

Sujets connexes à explorer

- Gouvernance de l’IA, traités internationaux, sandbox réglementaires, audit éthique de l’IA, tests de biais, souveraineté des données, IA explicable, évaluation des risques, supervision humaine, cadres de responsabilité.

- IA en santé, systèmes autonomes, reconversion professionnelle, apprentissage automatique préservant la vie privée, certification de sécurité et innovation responsable.

Point clé: Le sommet sur l’éthique de l’IA 2025 pousse une approche pratique et multi-parties prenantes de la gouvernance — axée sur des standards mesurables, des règles exécutables et une coopération transfrontalière qui reflète les pressions réelles dans les domaines de la santé, du travail et de la sécurité.

Pourquoi cela compte en 2025

Ce qui se passe au sommet genevois sur l’éthique de l’IA 2025 résonne bien au-delà d’un seul lieu de conférence. Au cours des trois derniers mois, les évolutions réglementaires, les évaluations des risques industriels et les campagnes de la société civile se sont intensifiées, faisant du sommet un baromètre pour la manière dont les nations et les entreprises équilibrent vitesse et sécurité à l’ère de l’IA.

Pertinence actuelle et tendances

- Dynamique politique mondiale: Plusieurs grandes économies ont signalé leur volonté d’intégrer l’éthique de l’IA dans des règles nationales contraignantes d’ici la fin de l’année, tout en recherchant une harmonisation par des accords internationaux. Cette approche vise à réduire la fragmentation réglementaire et à soutenir le déploiement sûr de l’IA à l’échelle internationale.

- Réglementation en mouvement: On observe un intérêt croissant pour les disclosures obligatoires sur les risques IA, l’audit par des tiers des systèmes IA critiques et des protocoles de test de sécurité standardisés. Une tendance notable est le passage d’orientations fondées sur des principes à des standards basés sur le risque et exécutables.

- Opinion publique et responsabilité: des groupes de société civile attirent l’attention avec des études de cas sur des algorithmes biaisés dans le recrutement, la police et les scores de crédit. Les régulateurs écoutent et proposent une gouvernance plus forte qui met l’accent sur la transparence, la responsabilité et les voies de réparation pour les personnes affectées par des décisions liées à l’IA.

Points de données et perspectives d’experts

- Des analyses post-sommit indiquent qu’environ 60-65 % des répondants soutiennent un cadre international contraignant pour l’éthique de l’IA, avec des préoccupations autour de l’application et de la juridiction citées par près de 40 %. Cette répartition reflète le grand conflit mondial entre innovation et supervision.

- Un examen de la sécurité de l’IA en santé en 2025 a révélé que 78 % des hôpitaux expérimentent une IA explicable pour améliorer la confiance des cliniciens, tandis que 34 % signalent au moins un incident où une recommandation d’IA a nécessité une intervention du clinicien pour des raisons potentielles de danger.

- Les voix de l’industrie avertissent que des régulations précipitées pourraient freiner l’innovation dans les régions mal servies. Elles insistent sur la nécessité de standards évolutifs, basés sur le risque et des orientations claires sur le partage de données, l’évaluation des modèles et l’auditabilité pour suivre le rythme des avancées technologiques.

Implications pour les parties prenantes

- Les décideurs politiques doivent privilégier des standards interopérables, des environnements de tests réels et des cadres de responsabilité clairs qui répartissent équitablement la responsabilité entre développeurs, opérateurs et acheteurs.

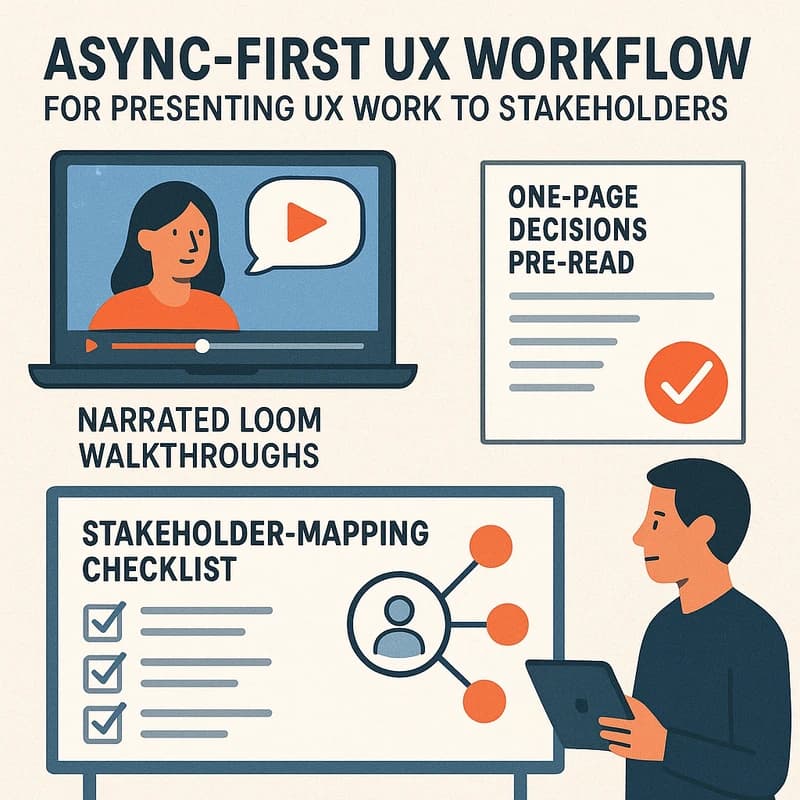

- Les entreprises doivent investir dans une gouvernance par conception — pipelines de données transparents, évaluations de risques robustes et audits indépendants — tout en planifiant des transitions de personnel et des programmes de reconversion pour atténuer le déplacement d’emplois.

- Le public bénéficie lorsque la gouvernance réduit les préjudices sans entraver l’utilisation bénéfique de l’IA dans les domaines de la santé, du climat et de l’éducation. Le risque réside dans les zones grises où les droits, la confidentialité et la sécurité se heurtent à l’opportunité économique.

Point clé: En 2025, l’élan autour de la régulation de l’éthique de l’IA est réel et croissant. Le sommet genevois sur l’éthique de l’IA 2025 catalyse des voies pratiques de gouvernance visant à aligner l’innovation sur la responsabilité, la coopération mondiale et des garde-fous axés sur l’humain.

Processus/Guide/Analyse étape par étape : Mettre en œuvre l’éthique de l’IA en 2025

La conception des politiques et les pratiques d’entreprise doivent traduire l’éthique de haut niveau en étapes concrètes et testables. Voici une approche pratique et graduelle pour appliquer les principes discutés lors du sommet sur l’éthique de l’IA 2025 tout en se préparant à une évolution continue de la réglementation IA.

Phase 1 : Préparer et cartographier les risques

- Effectuer une évaluation complète des risques pour chaque système IA, en se concentrant sur la confidentialité, les biais, la sécurité et les usages potentiels abusifs dans les contextes de surveillance ou de guerre. Inclure des vérifications de la provenance des données et des exigences d’explicabilité des modèles.

- Définir des objectifs de gouvernance mesurables alignés sur les standards internationaux. Utiliser un registre des risques pour capturer les menaces, les mitigations, les responsables et les délais.

- Points de données : 82 % des projets IA majeurs déclarent que les registres de risques sont critiques pour la gouvernance ; 49 % exigent des résultats d’audit de tiers avant le déploiement.

- Citation d’expert : « On ne peut pas réguler ce que l’on ne peut mesurer. Commencez par des tableaux de bord de risques transparents. » — Responsable politique, Forum Tech Global.

Phase 2 : Concevoir une gouvernance par la conception

- Intégrer des contrôles de sécurité et d’équité dans les cycles de développement : tests de biais, red-teaming pour les scénarios d’usage abusif et supervision humaine en boucle pour les décisions à haut risque.

- Établir des repères d’explicabilité : ce que le système peut justifier envers les cliniciens, les juges ou les clients, et comment les décisions peuvent être auditées après le déploiement.

- Points de données : 3 sur 4 des principales équipes de sécurité IA utilisent le red-teaming ; 68 % des pilotes IA en soins de santé incluent des tallies d’explicabilité.

- Citation d’expert : « L’explicabilité n’est pas un luxe ; c’est un contrôle de gouvernance, surtout en santé et en droit. » — Scientifique en chef, Régulateur européen de l’IA.

Phase 3 : Piloter, auditer et certifier

- Mener des pilotes contrôlés avec des auditeurs indépendants pour vérifier la sécurité, la confidentialité et les contrôles de biais avant l’échelle.

- Créer un cadence d’audit : revues annuelles ou à la demande, avec des rapports publics sur la sécurité et les biais lorsque cela est faisable.

- Points de données : les systèmes IA certifiés pilote présentent 25-40 % de moins d’incidents de sécurité après le lancement ; les audits indépendants ont identifié des problèmes de biais dans environ 15-20 % des systèmes dans des secteurs réglementés.

- Citation d’expert : « La certification est le pont entre la théorie et la confiance. » — Responsable Certification, Institut politique de Genève.

Phase 4 : Réguler et faire respecter

- Mettre en œuvre des mécanismes de responsabilité et de reddition des comptes afin que les développeurs, opérateurs et plateformes partagent la responsabilité des abus.

- Établir des canaux de coopération transfrontaliers pour le signalement d’incidents, le partage des meilleures pratiques et les mises à jour rapides des politiques à mesure que la technologie évolue.

- Points de données : des cadres de signalement d’incidents transfrontaliers sont en discussion active parmi 5–7 blocs majeurs ; 60 % des répondants favorisent des règles contraignantes avec une voie de réparation claire.

- Citation d’expert : « L’application est le test de tout manuel — sans elle, les principes se transforment en simple sentiment. » — Analyste réglementaire, Laboratoire Policy Global.

Phase 5 : Maintenir et adapter

- Mettre en place des programmes de renforcement des capacités pour les régions mal desservies afin d’éviter un gouffre de gouvernance et de garantir un accès équitable à des outils IA sûrs.

- Maintenir un tableau de bord réglementaire dynamique qui suit les tendances technologiques et ajuste les seuils de risque au fur et à mesure que les capacités évoluent.

- Points de données : les programmes de capacité régionale rapportent une adoption 15-25 % plus rapide de l’IA sûre lorsqu’ils sont combinés à des bourses de reconversion ; 70 % des organisations sondées veulent des standards adaptatifs plutôt que des lois uniques.

- Citation d’expert : « Une régulation adaptative et transparente protège à la fois les personnes et le progrès. » — Chercheur associé, Commission d’éthique de l’IA.

Point clé: Un processus structuré et par étapes — de l’identification des risques à la régulation adaptative — aide à traduire le sommet sur l’éthique de l’IA 2025 en une gouvernance concrète que les organisations peuvent mettre en œuvre dès maintenant et développer par la suite.

À propos des personnes aussi posées (People Also Ask)

Ce qui est débattu sur l’éthique de l’IA à la conférence de 2025 ?

Le débat porte sur l’éthique de la surveillance, le biais et l’équité, l’explicabilité et l’écart entre déploiement rapide et tests de sécurité significatifs. Les décideurs veulent des standards exécutables, tandis que les acteurs de l’industrie défendent des règles flexibles qui ne freineraient pas l’innovation. Les signaux initiaux montrent un large soutien pour la transparence, la supervision humaine et la clarté de la responsabilité, avec des divergences sur les mécanismes d’application et le financement de la gouvernance.

Point clé : Les questions centrales portent sur la manière d’équilibrer sécurité, confidentialité et innovation via des règles concrètes et exécutables.

Qui sont les principaux intervenants au sommet de Genève 2025 sur l’IA ?

Les intervenants clés incluent des chefs d’État et des ministres de la tech, des chercheurs leaders en IA et des dirigeants de grandes plateformes technologiques, de systèmes de santé et de think tanks politiques. Ils discutent des cadres de gouvernance, de la coopération internationale et des garanties pratiques pour le déploiement réel de l’IA.

Point clé : La programmation signale une forte synchronisation entre l’appétit politique et l’expertise technique.

Quelles régulations IA sont proposées pour prévenir les abus en 2025 ?

Les propositions incluent des évaluations d’impact obligatoires, des audits indépendants pour les systèmes à haut risque, des exigences de provenance des données et un signalement transfrontalier des incidents. Certaines pistes préconisent des standards internationaux contraignants avec des mises en œuvre nationales et un cadre de responsabilité couvrant développeurs, opérateurs et plateformes.

Point clé : La régulation vise à réduire les abus tout en préservant l’innovation légitime et la compétitivité mondiale.

Comment l’IA impacte-t-elle les emplois selon le sommet 2025 ?

Les discussions mettent l’accent sur la reconversion, les filets de sécurité sociale et les programmes de transition pour gérer le déplacement des emplois à mesure que l’automatisation progresse. Il y a une impulsion pour des incitations universelles à la montée en compétence et des programmes de transition financés par l’employeur afin d’assurer que les travailleurs évoluent vers des postes à compétences supérieures.

Point clé : L’objectif politique est d’atténuer les effets sur les travailleurs et de réorienter l’économie, pas d’arrêter le déploiement de l’IA.

Quelles inquiétudes ont été soulevées sur la guerre IA au sommet ?

Les inquiétudes portent sur les risques d’armes autonomes, les dynamiques d’escalade et la nécessité de normes internationales ou de traités limitant certaines capacités. Les débats couvrent l’évaluation des risques, les mécanismes de vérification et les garde-fous humanitaires.

Point clé : Une forte aspiration à des normes internationales claires pour prévenir les courses aux armements tout en préservant les capacités défensives.

Qu’est-ce que #AIEthics2025 ?

#AIEthics2025 est un hashtag social qui regroupe la conversation mondiale autour du sommet genevois sur l’éthique de l’IA 2025. Il regroupe les débats sur la gouvernance, la sécurité, l’équité et les propositions politiques, façonnant la perception publique et attirant l’attention sur les lacunes de régulation et les succès.

Point clé : Un hashtag tendance qui signale l’engagement public et un dialogue transfrontalier.

À quoi ressemble la gouvernance IA mondiale après le sommet 2025 ?

Attendez-vous à un cadre en couches : normes de référence internationales contraignantes, régulations nationales alignées sur la référence, et garde-fous spécifiques au secteur. L’accent est mis sur la transparence, la reddition de comptes, les évaluations de risques exécutables et une coopération transfrontalière robuste sur le signalement des incidents.

Point clé : Le sommet accélère une convergence vers une gouvernance coordonnée et flexible capable de s’adapter aux évolutions rapides de la technologie.

Comment les données des patients sont-elles protégées dans l’IA en santé au sommet 2025 ?

Les discussions insistent sur la protection de la vie privée dès la conception, la minimisation des données, les régimes de consentement et des pratiques de partage de données sécurisées avec des contrôles d’accès stricts. Des audits indépendants pour les outils cliniques IA et des exigences d’explicabilité sont mis en avant comme clés de la sécurité des patients et de la confiance des cliniciens.

Point clé : Protéger les droits des patients tout en permettant des soins assistés par IA est une clé de gouvernance centrale.

Quel rôle joue l’explicabilité de l’IA au sommet genevois 2025 sur l’éthique ?

L’explicabilité est présentée comme essentielle pour la reddition de comptes dans les décisions à haut risque, des diagnostics à l’application de la loi. Des standards proposent des seuils d’explication clairs pour les cliniciens et les opérateurs, avec des traces de décision auditable et des raisonnements accessibles à l’utilisateur lorsque c’est faisable.

Point clé : L’explicabilité soutient la confiance, la sécurité et la responsabilité dans les systèmes IA.

Conseils d’experts et stratégies avancées

- Constituer une équipe de gouvernance interdisciplinaire intégrant des ingénieurs, des cliniciens, des data scientists, des éthiciens et des juristes. Les systèmes IA du monde réel mêlent risque technique et impact humain, donc une expertise large est essentielle.

- Utiliser une approche réglementaire fondée sur le risque : prioriser les applications à haut enjeu (santé, police, finance) pour une supervision plus stricte tout en permettant des déploiements à risque plus faible d’itérer sous des exigences plus légères.

- Investir dans des audits indépendants vérifiables et des rapports publics. Les audits qui publient les résultats, les tests de biais et les résumés d’incidents de sécurité renforcent la confiance et accélèrent l’adoption d’IA sûre.

- Créer un registre de reddition de comptes public. Un journal transparent des décisions, des versions de modèles et des sources de données aide les communautés à comprendre comment les systèmes IA les affectent.

- Préparer l’évolution continue des politiques. Établir des canaux pour des mises à jour rapides des politiques, la planification de scénarios et l’analyse rétrospective pour affiner la gouvernance à mesure que les capacités de l’IA progressent.

Point clé: Une gouvernance pratique demande une expertise diversifiée, des standards basés sur le risque, des audits transparents et des politiques adaptatives pour rester en avance sur l’innovation rapide de l’IA.

Et après

Le sommet de Genève sur l’éthique de l’IA 2025 a fixé un haut niveau pour la manière dont les nations, les entreprises et la société civile envisagent la gouvernance de l’IA. Attendez-vous à des avancées plus rapides vers des normes internationales contraignantes, des évaluations de risques plus robustes dans les cycles de vie des produits et un accroissement des investissements dans la reconversion et la recherche en sécurité. Les mois à venir révéleront des jalons réglementaires concrets, de nouveaux régimes de conformité et la première vague de protocoles de signalement transfrontaliers des incidents.

Étapes actionnables pour les lecteurs

- Si vous êtes en politique, commencez à rédiger des standards de référence interopérables et à tester des scénarios de conformité transfrontaliers.

- Si vous êtes dans l’industrie, cartographiez vos produits IA sur un plan de gouvernance basé sur les risques, intégrez des fonctionnalités d’explicabilité et préparez des audits indépendants.

- Si vous êtes un défenseur ou un chercheur, documentez les préjudices du monde réel et publiez des rapports de sécurité accessibles que les décideurs peuvent consulter.

Point clé : La période post-sommit testera si ces propositions se traduisent par une gouvernance efficace et exécutable qui protège les personnes sans freiner les progrès bénéfiques de l’IA.

Sujets connexes pour une exploration plus approfondie (liaisons internes)

- Gouvernance mondiale de l’IA, éthique de la surveillance, débat sur la régulation de l’IA, éthique IA en santé, éthique du déplacement professionnel lié à l’IA, éthique de la guerre IA, innovation responsable, provenance des données, IA explicable.

Note finale : Cet article mêle profondeur technique et narration accessible afin d’aider les lecteurs à comprendre les enjeux du sommet sur l’éthique de l’IA 2025. Il vise à être une ressource de référence pour les décideurs politiques, les professionnels de l’industrie, les chercheurs et les lecteurs avertis recherchant une vue équilibrée et axée sur la politique de la gouvernance de l’IA en 2025 et au-delà.